Webサイトを検索エンジンに最適化するには、robots.txtの正しい活用が欠かせません。

このファイルを活用することで、SEOの効率化や不要なクロールの回避など、多くのメリットが得られます。

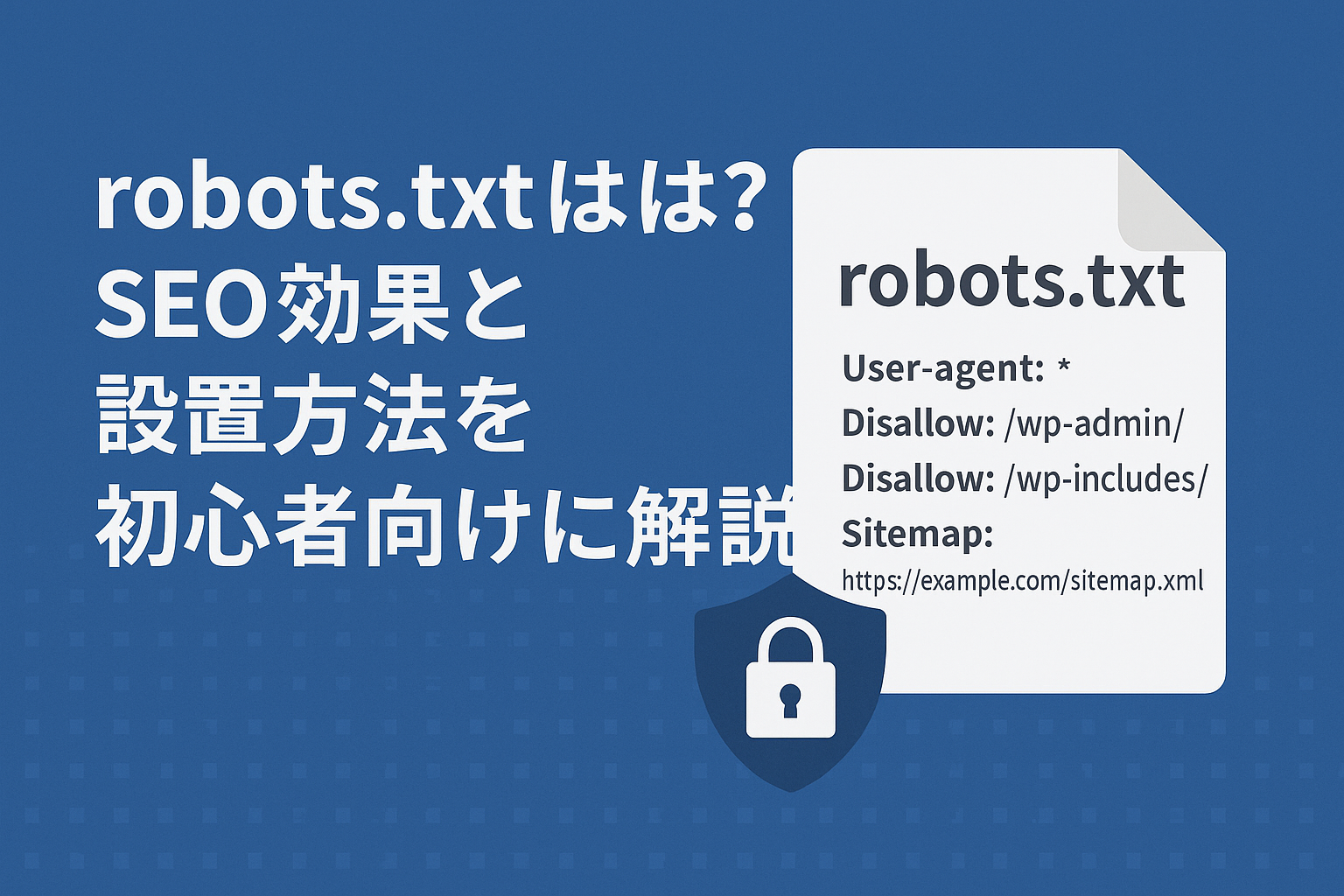

robots.txtとは?

robots.txtは、検索エンジンのクローラーに対して「このページは見てOK」「ここは見ないで」と指示するためのファイルです。サイトのルートディレクトリに設置し、クローラーの動きを制御できます。

例えるなら、サイト内の「立ち入り禁止エリア」を伝える案内板のような役割です。

robots.txtを設置するSEO的メリット

- 不要なクロールを防ぐ:ログイン画面やシステムファイルなどを除外できる

- 重要なページのクロール効率を上げる:巡回リソースが集中しやすくなる

- サーバー負荷を軽減:無駄なアクセスを減らすことでリソース節約に

- XMLサイトマップを伝えられる:より正確なサイト構造を検索エンジンに伝達できる

おすすめのrobots.txt記述例(WordPress向け)

以下のように書くのが基本です。sitemapのURLはご自身のものに変更してください。

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Sitemap: https://example.com/sitemap.xml設置方法①:手動でrobots.txtを作成・アップロード

メモ帳やエディタを使って、自分でファイルを作成・アップロードする方法です。

- メモ帳やVS Codeなどで

robots.txtという名前でファイルを作成 - 上記の記述例をコピーして貼り付ける

- 以下の保存形式の注意点を確認

- サーバーのルートディレクトリにアップロード

https://example.com/robots.txtで表示されれば成功!

保存形式の注意点

- 文字コード:

UTF-8(BOMなし)が推奨です。

Windowsのメモ帳で保存するとBOM付きになる場合があるため、VS CodeやTeraPadなどのエディタがおすすめです。 - 改行コード: 基本的に

LF(Unix形式)推奨ですが、CRLF(Windows形式)でもGoogleは問題なく読み取れます。 - ファイル名は必ず小文字で

robots.txtとし、拡張子も忘れずに。

初心者におすすめの無料テキストエディタ

- VS Code:エンコーディングと改行コードが明示されていて安心

- TeraPad:Windows向けの軽量エディタ。BOMの有無も指定可能

- サクラエディタ:Windowsユーザー定番の多機能エディタ

設置方法②:WordPressプラグインで生成

初心者はプラグインを使うと簡単に設定できます。

Yoast SEOの場合

- WordPress管理画面 → SEO → ツール

- 「ファイルエディタ」から robots.txt を作成

- 内容を記述して保存

All in One SEOの場合

- All in One SEO → ツール → robots.txtエディタ

- 「有効にする」にチェックを入れる

- 内容を編集して保存

設置後の確認方法

以下のURLにアクセスして、ファイルが正しく表示されるか確認します。

https://example.com/robots.txtさらに正確な動作確認をしたい場合は、Google Search Console の「robots.txt テスター」機能を活用しましょう。

よくある質問

- Q. 設置しないとSEOに悪影響?

→ 大きな悪影響はありませんが、無駄なクロールが発生しやすくなります。 - Q. Disallowすればインデックスされませんか?

→ いいえ。クロールを防ぐだけで、インデックスにはnoindexの使用が必要です。 - Q. UTF-8(BOMなし)で保存する方法がわかりません

→ 無料エディタ(VS CodeやTeraPadなど)を使うと、保存時に選べるので安心です。

まとめ

robots.txtは検索エンジンに不要な巡回を制限する便利なファイル- SEOの効率化やサーバー保護にも効果的

- 文字コードや改行コードなど、正しい形式で保存・設置するのが重要

検索エンジンに好まれるサイトづくりの第一歩として、robots.txtをぜひ活用してみてください!

Web制作やHTML/CSSの学習に役立つ情報を初心者向けに発信しています。

プロフィールはこちら